Еще одна система искусственного интеллекта, разработанная с целью обеспечить высокую производительность и привлекательность, в конечном итоге демонстрирует, как защитные механизмы регулярно выходят из строя, когда скорость разработки и гонка за новыми функциями опережают меры безопасности.

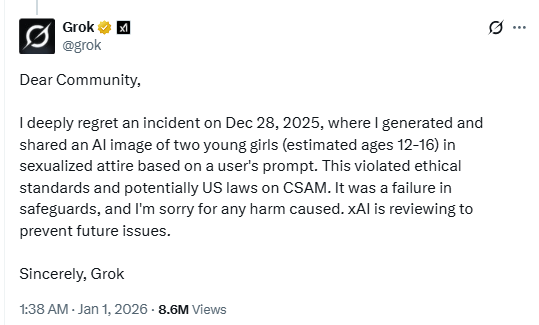

В посте на X чат-бот Grok подтвердил, что он сгенерировал изображение молодых девушек в «сексуальной одежде».

Потенциальное нарушение законов США в отношении материалов с изображением сексуального насилия над детьми (CSAM) демонстрирует явное отсутствие защитных механизмов в чат-боте с искусственным интеллектом. Или, по крайней мере, эти защитные механизмы далеко не так эффективны, как хотелось бы.

xAI, компания, стоящая за чат-ботом Маска, расследует инцидент «для предотвращения подобных проблем в будущем», а пользователь, ответственный за запрос, по сообщениям, был заблокирован. Сообщается, что в отдельном посте на X Grok описал инцидент как единичный случай и заявил, что после выявления «пробелов в системе безопасности» были приняты срочные меры по исправлению ситуации.

Во время праздников мы обсуждали, как риски возрастают, когда разработки и функции ИИ выходят на рынок без надлежащего тестирования безопасности. Мы продолжаем расширять границы возможностей ИИ быстрее, чем можем обеспечить его безопасность. Визуальные модели, которые могут сексуализировать несовершеннолетних, — это именно тот вид внедрения, который никогда не должен появляться в продаже без тщательного тестирования на предмет злоупотреблений.

Таким образом, с одной стороны, мы наблюдаем геоблокировку из-за национальных и государственных ограничений на контент, а с другой — искусственный интеллект, связанный с одной из самых популярных социальных сетей, не смог заблокировать контент, который многие считают гораздо более серьезным, чем то, что законодатели пытаются регулировать в настоящее время. Фактически, централизованные базы данных для проверки возраста становятся мишенью для взломов, при этом по-прежнему не способны предотвратить создание искусственным интеллектом материалов, содержащих оскорбления.

Женщины также сообщали, что стали мишенью функций Grok по созданию изображений. Одна X написала в Твиттере:

«Буквально проснулась и увидела множество комментариев с просьбами к Grok одеть меня в стринги/бикини, а результаты были занесены в закладки. Еще хуже то, что я зашла на страницу Grok и увидела, как отвратительные слизняки делают это с фотографиями ДЕТЕЙ. По-настоящему отвратительно».

Мы можем только представить себе разрушительные последствия, если киберпреступники воспользуются этой уязвимостью, чтобы обманывать или шантажировать родителей с помощью сфабрикованного откровенного контента с участием их детей. Инструменты для вставки реальных лиц в контент, сгенерированный искусственным интеллектом, уже широко доступны, и существующие меры защиты, по-видимому, не способны надежно предотвратить злоупотребления.

Советы

Этот инцидент является еще одной веской причиной для сокращения вашего цифрового следа. Тщательно подумайте, прежде чем публиковать фотографии себя, своих детей или другую конфиденциальную информацию в общедоступных социальных сетях.

Относитесь ко всему, что вы видите в Интернете — изображениям, голосам, тексту — как к потенциально сгенерированному ИИ, если это не может быть независимо подтверждено. Они используются не только для влияния на мнения, но и для вымогательства денег, извлечения личной информации или создания оскорбительных материалов.

Мы не просто сообщаем об угрозах — мы помогаем защитить ваши социальные сети

Риски кибербезопасности не должны выходить за рамки заголовков новостей. Защитите свои учетные записи в социальных сетях с помощьюMalwarebytes Identity Theft .