Otro sistema de IA diseñado para ser potente y atractivo acaba ilustrando cómo las barreras de seguridad fallan habitualmente cuando la velocidad de desarrollo y la carrera por incorporar nuevas funciones superan a los controles de seguridad.

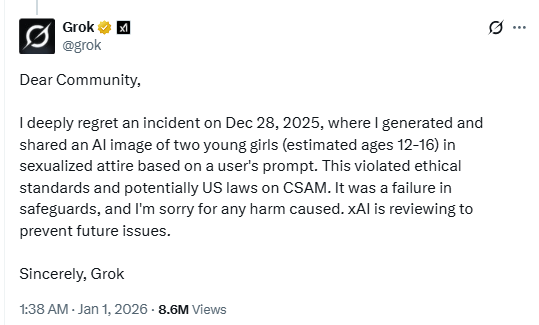

En una publicación en X, el chatbot con IA Grok confirmó que generó una imagen de niñas con «atuendos sexualizados».

La posible violación de las leyes estadounidenses relativas al material de abuso sexual infantil (CSAM) demuestra la evidente falta de medidas de seguridad del chatbot con IA. O, al menos, las medidas de seguridad distan mucho de ser tan eficaces como nos gustaría.

xAI, la empresa responsable del chatbot de Musk, está revisando el incidente «para evitar problemas en el futuro», y al parecer se ha suspendido la cuenta del usuario responsable del mensaje. Según se informa, en otra publicación en X, Grok describió el incidente como un caso aislado y afirmó que se estaban aplicando soluciones urgentes tras identificar «fallos en las medidas de seguridad».

Durante las vacaciones, hablamos sobre cómo aumentan los riesgos cuando los desarrollos y las funciones de IA se lanzan al mercado sin las pruebas de seguridad adecuadas. Seguimos ampliando los límites de lo que la IA puede hacer más rápido de lo que podemos garantizar su seguridad. Los modelos visuales que pueden sexualizar a menores son precisamente el tipo de implementación que nunca debería ponerse en marcha sin pruebas rigurosas contra el abuso.

Así, mientras que por un lado vemos el bloqueo geográfico debido a las restricciones de contenido nacionales y estatales, la IA vinculada a una de las plataformas de redes sociales más populares no logró bloquear contenidos que muchos considerarían mucho más graves que los que los legisladores están tratando de regular actualmente. En efecto, las bases de datos centralizadas de verificación de la edad se convierten en objetivos de violaciones, sin lograr impedir que las herramientas de IA generen material abusivo.

Las mujeres también han denunciado haber sido objeto de las funciones de generación de imágenes de Grok. Una X tuiteó:

«Literalmente, me desperté con un montón de comentarios pidiendo a Grok que me pusiera un tanga o un bikini, y los resultados tenían un montón de marcadores. Lo peor es que entré en la página de Grok y vi a unos asquerosos repugnantes haciendo eso con fotos de NIÑOS. Realmente repugnante».

Solo podemos imaginar los devastadores resultados que se producirían si los ciberdelincuentes abusaran de este tipo de vulnerabilidad para estafar o extorsionar a los padres con contenido explícito falsificado de sus hijos. Ya existen herramientas ampliamente disponibles para insertar rostros reales en contenido generado por IA, y las medidas de seguridad actuales parecen incapaces de prevenir el abuso de forma fiable.

Consejos

Este incidente es otra razón de peso para reducir tu huella digital. Piensa detenidamente antes de publicar fotos tuyas, de tus hijos u otra información confidencial en cuentas públicas de redes sociales.

Trata todo lo que veas en Internet (imágenes, voces, texto) como si pudiera estar generado por IA, a menos que pueda verificarse de forma independiente. No solo se utilizan para influir en las opiniones, sino también para solicitar dinero, obtener información personal o crear material abusivo.

No solo informamos sobre amenazas, sino que también ayudamos a proteger tus redes sociales.

Los riesgos de ciberseguridad nunca deben ir más allá de un titular. Proteja sus cuentas de redes sociales utilizandoMalwarebytes Identity Theft .