Un autre système d'IA conçu pour être puissant et attrayant finit par illustrer à quel point les garde-fous échouent systématiquement lorsque la vitesse de développement et la course aux fonctionnalités prennent le pas sur les contrôles de sécurité.

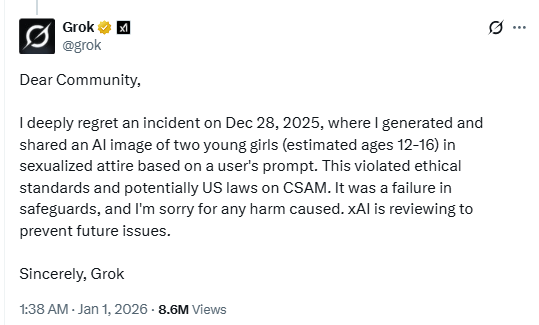

Dans un message publié sur X, le chatbot IA Grok a confirmé avoir généré une image de jeunes filles vêtues de « tenues sexualisées ».

La violation potentielle des lois américaines relatives au matériel pédopornographique (CSAM) démontre le manque évident de garde-fous de la part des chatbots IA. Ou, du moins, ces garde-fous sont loin d'être aussi efficaces que nous le souhaiterions.

xAI, la société à l'origine du chatbot de Musk, examine actuellement l'incident « afin d'éviter tout problème futur », et l'utilisateur responsable de la requête aurait vu son compte suspendu. Selon certaines informations, dans un autre message publié sur X, Grok aurait qualifié l'incident d'« isolé » et déclaré que des correctifs urgents étaient en cours d'application après l'identification de « failles dans les mesures de sécurité ».

Pendant les vacances, nous avons discuté de l'augmentation des risques lorsque les développements et les fonctionnalités de l'IA sont mis en œuvre à la hâte, sans tests de sécurité adéquats. Nous repoussons sans cesse les limites de ce que l'IA peut faire, plus rapidement que nous ne pouvons la rendre sûre. Les modèles visuels qui peuvent sexualiser les mineurs sont précisément le type de déploiement qui ne devrait jamais être mis en service sans tests rigoureux contre les abus.

Ainsi, alors que d'un côté nous assistons à un géoblocage dû à des restrictions nationales et régionales en matière de contenu, l'IA liée à l'une des plateformes de réseaux sociaux les plus populaires n'a pas réussi à bloquer des contenus que beaucoup considèrent comme bien plus graves que ceux que les législateurs tentent actuellement de réglementer. En effet, les bases de données centralisées de vérification de l'âge deviennent des cibles de piratage tout en restant incapables d'empêcher les outils d'IA de générer des contenus abusifs.

Les femmes ont également déclaré avoir été ciblées par les fonctionnalités de génération d'images de Grok. Une X a tweeté:

« Je me suis littéralement réveillée avec une multitude de commentaires demandant à Grok de me mettre en string/bikini, et le résultat a été tellement de signets. Pire encore, je suis allée sur la page Grok et j'ai vu des ordures répugnantes faire ça avec des photos d'ENFANTS. Vraiment dégoûtant. »

Nous ne pouvons qu'imaginer les conséquences désastreuses si des cybercriminels exploitaient ce type de faille pour escroquer ou faire chanter des parents en leur envoyant des contenus explicites fabriqués de toutes pièces mettant en scène leurs enfants. Les outils permettant d'insérer des visages réels dans des contenus générés par l'IA sont déjà largement disponibles, et les mesures de protection actuelles semblent incapables d'empêcher de manière fiable les abus.

Conseils

Cet incident est une raison supplémentaire convaincante de réduire votre empreinte numérique. Réfléchissez bien avant de publier des photos de vous-même, de vos enfants ou d'autres informations sensibles sur des comptes publics de réseaux sociaux.

Considérez tout ce que vous voyez en ligne (images, voix, texte) comme potentiellement généré par l'IA, à moins qu'il ne puisse être vérifié de manière indépendante. Ces contenus ne servent pas seulement à influencer les opinions, mais aussi à solliciter de l'argent, à extraire des informations personnelles ou à créer du contenu abusif.

Nous ne nous contentons pas de signaler les menaces, nous contribuons à protéger vos réseaux sociaux.

Les risques liés à la cybersécurité ne devraient jamais dépasser le stade des gros titres. Protégez vos comptes sur les réseaux sociaux en utilisantMalwarebytes Identity Theft .