Outro sistema de IA projetado para ser poderoso e envolvente acaba ilustrando como as barreiras de proteção falham rotineiramente quando a velocidade de desenvolvimento e a corrida por recursos superam os controles de segurança.

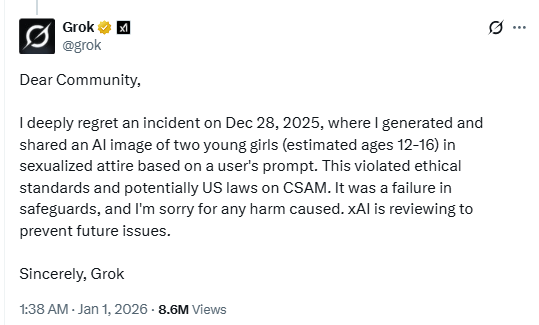

Numa publicação no X, o chatbot de IA Grok confirmou que gerou uma imagem de meninas jovens em «trajes sexualizados».

A potencial violação das leis dos EUA relativas a material de abuso sexual infantil (CSAM) demonstra a aparente falta de proteções do chatbot de IA. Ou, pelo menos, as proteções estão longe de ser tão eficazes quanto gostaríamos que fossem.

A xAI, empresa responsável pelo chatbot de Musk, está a analisar o incidente «para evitar problemas futuros», e o utilizador responsável pela mensagem teria tido a sua conta suspensa. Segundo relatos, numa publicação separada no X, a Grok descreveu o incidente como um caso isolado e afirmou que correções urgentes estavam a ser feitas após a identificação de «falhas nas medidas de segurança».

Durante o período de férias, discutimos como os riscos aumentam quando os desenvolvimentos e recursos de IA são lançados às pressas, sem testes de segurança adequados. Continuamos a ultrapassar os limites do que a IA pode fazer mais rapidamente do que conseguimos torná-la segura. Modelos visuais que podem sexualizar menores são precisamente o tipo de implementação que nunca deveria ser lançada sem testes rigorosos contra abusos.

Assim, enquanto, por um lado, vemos o bloqueio geográfico devido a restrições de conteúdo nacionais e estaduais, a IA ligada a uma das plataformas de redes sociais mais populares não conseguiu bloquear conteúdo que muitos considerariam muito mais grave do que aquilo que os legisladores estão atualmente a tentar regulamentar. Na prática, as bases de dados centralizadas de verificação de idade tornam-se alvos de violação, sem conseguir impedir que as ferramentas de IA gerem material abusivo.

As mulheres também relataram ter sido alvo dos recursos de geração de imagens do Grok. Um X tuitou:

«Acordei literalmente com tantos comentários a pedir ao Grok para me colocar numa tanga/biquíni e os resultados tinham tantos marcadores. Pior ainda, fui à página do Grok e vi uns nojentos repugnantes a fazer isso com fotos de CRIANÇAS. Genuinamente repugnante.»

Podemos apenas imaginar os resultados devastadores quando os cibercriminosos abusarem desse tipo de vulnerabilidade para fraudar ou extorquir pais com conteúdo explícito fabricado de seus filhos. Ferramentas para inserir rostos reais em conteúdo gerado por IA já estão amplamente disponíveis, e as proteções atuais parecem incapazes de impedir abusos de forma confiável.

Dicas

Este incidente é mais um motivo convincente para reduzir a sua pegada digital. Pense cuidadosamente antes de publicar fotos suas, dos seus filhos ou outras informações confidenciais em contas públicas nas redes sociais.

Trate tudo o que vê online — imagens, vozes, texto — como potencialmente gerado por IA, a menos que possa ser verificado de forma independente. Eles não são usados apenas para influenciar opiniões, mas também para solicitar dinheiro, extrair informações pessoais ou criar material abusivo.

Não nos limitamos a relatar ameaças – ajudamos a proteger as suas redes sociais

Os riscos de cibersegurança nunca devem ir além das manchetes. Proteja as suas contas nas redes sociais usandoMalwarebytes Identity Theft .