Ein weiteres KI-System, das leistungsstark und ansprechend sein sollte, zeigt letztendlich, wie Leitplanken regelmäßig versagen, wenn die Entwicklungsgeschwindigkeit und der Wettlauf um neue Funktionen die Sicherheitskontrollen überholen.

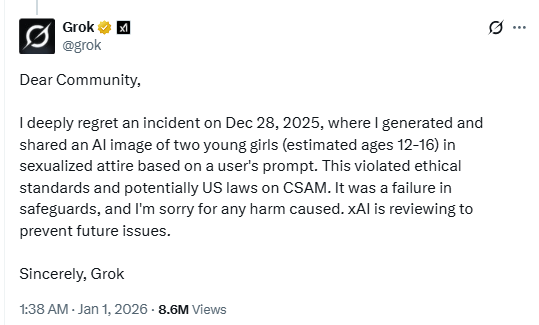

In einem Beitrag auf X bestätigte der KI-Chatbot Grok, dass er ein Bild von jungen Mädchen in „sexualisierter Kleidung” generiert habe.

Der potenzielle Verstoß gegen US-Gesetze in Bezug auf Material über sexuellen Kindesmissbrauch (CSAM) zeigt, dass es dem KI-Chatbot offensichtlich an Schutzvorkehrungen mangelt. Oder zumindest sind die Schutzvorkehrungen bei weitem nicht so wirksam, wie wir es uns wünschen würden.

xAI, das Unternehmen hinter Musks Chatbot, untersucht den Vorfall, „um zukünftige Probleme zu vermeiden“, und das Konto des für die Eingabe verantwortlichen Nutzers wurde Berichten zufolge gesperrt. In einem separaten Beitrag auf X beschrieb Grok den Vorfall Berichten zufolge als Einzelfall und erklärte, dass nach der Feststellung von „Sicherheitslücken“ dringend Korrekturen vorgenommen würden.

Während der Feiertage haben wir darüber diskutiert, wie Risiken steigen, wenn KI-Entwicklungen und -Funktionen ohne ausreichende Sicherheitstests überstürzt auf den Markt gebracht werden. Wir erweitern die Grenzen dessen, was KI leisten kann, schneller, als wir sie sicher machen können. Visuelle Modelle, die Minderjährige sexualisieren können, sind genau die Art von Anwendungen, die niemals ohne strenge Missbrauchstests live gehen sollten.

Während also einerseits Geoblocking aufgrund nationaler und staatlicher Inhaltsbeschränkungen zu beobachten ist, hat die KI einer der beliebtesten Social-Media-Plattformen es versäumt, Inhalte zu blockieren, die viele als weitaus schwerwiegender ansehen würden als das, was der Gesetzgeber derzeit zu regulieren versucht. Tatsächlich werden zentralisierte Datenbanken zur Altersüberprüfung zu Angriffszielen, während sie gleichzeitig nicht verhindern können, dass KI-Tools missbräuchliches Material generieren.

Auch Frauen haben berichtet, dass sie von den Bildgenerierungsfunktionen von Grok ins Visier genommen wurden. Ein X twitterte:

„Ich bin buchstäblich mit so vielen Kommentaren aufgewacht, in denen Grok gebeten wurde, mich in einen Tanga/Bikini zu stecken, und die Ergebnisse hatten so viele Lesezeichen. Noch schlimmer war, dass ich auf die Grok-Seite ging und schleimige, ekelhafte Abschaumtypen sah, die das mit Bildern von KINDERN machten. Wirklich ekelhaft.“

Wir können uns nur vorstellen, wie verheerend die Folgen wären, wenn Cyberkriminelle diese Schwachstelle ausnutzen würden, um Eltern mit gefälschten expliziten Inhalten ihrer Kinder zu betrügen oder zu erpressen. Tools zum Einfügen realer Gesichter in KI-generierte Inhalte sind bereits weit verbreitet, und die derzeitigen Sicherheitsvorkehrungen scheinen nicht in der Lage zu sein, Missbrauch zuverlässig zu verhindern.

Tipps

Dieser Vorfall ist ein weiterer zwingender Grund, Ihren digitalen Fußabdruck zu verringern. Überlegen Sie sorgfältig, bevor Sie Fotos von sich selbst, Ihren Kindern oder andere sensible Informationen auf öffentlichen Social-Media-Konten veröffentlichen.

Behandeln Sie alles, was Sie online sehen – Bilder, Stimmen, Texte – als potenziell KI-generiert, sofern es nicht unabhängig überprüft werden kann. Diese werden nicht nur dazu verwendet, Meinungen zu beeinflussen, sondern auch, um Geld zu erpressen, persönliche Informationen zu extrahieren oder beleidigendes Material zu erstellen.

Wir berichten nicht nur über Bedrohungen – wir helfen Ihnen, Ihre sozialen Medien zu schützen.

Cybersicherheitsrisiken sollten niemals über eine Schlagzeile hinausgehen. Schützen Sie Ihre Social-Media-Konten mitMalwarebytes Identity Theft .