Onderzoekers hebben een methode gevonden om gegevens te stelen die de ingebouwde veiligheidsmechanismen van Microsoft Copilot omzeilt.

De aanval, genaamd Reprompt, maakt misbruik van de manier waarop Microsoft Copilot URL-parameters verwerkt om de bestaande Copilot Personal-sessie van een gebruiker te kapen.

Copilot is een AI-assistent die verbinding maakt met een persoonlijk account en is geïntegreerd in Windows, de Edge en verschillende consumententoepassingen.

Het probleem is opgelost in de Patch Tuesday-update van Microsoft van januari en tot nu toe zijn er geen aanwijzingen dat er misbruik van is gemaakt. Toch laat het eens te meer zien hoe riskant het op dit moment kan zijn om AI-assistenten te vertrouwen.

Reprompt verbergt een kwaadaardige prompt in de q-parameter van een verder legitieme Copilot-URL. Wanneer de pagina wordt geladen, voert Copilot die prompt automatisch uit, waardoor een aanvaller met slechts één klik op een phishinglink acties kan uitvoeren in de geauthenticeerde sessie van het slachtoffer.

Met andere woorden, aanvallers kunnen geheime instructies verbergen in het webadres van een Copilot-link, op een plek waar de meeste gebruikers nooit kijken. Copilot voert die verborgen instructies vervolgens uit alsof de gebruikers ze zelf hebben ingetypt.

Omdat Copilot prompts accepteert via een q URL-parameter en deze automatisch uitvoert, kan een phishing-e-mail een gebruiker verleiden om op een legitiem ogende Copilot-link te klikken, terwijl er stilletjes door de aanvaller gecontroleerde instructies in een live Copilot-sessie worden geïnjecteerd.

Wat Reprompt onderscheidt van andere, vergelijkbare prompt-injectieaanvallen, is dat er geen door de gebruiker ingevoerde prompts, geïnstalleerde plug-ins of ingeschakelde connectoren nodig zijn.

De basis van de Reprompt-aanval is verbazingwekkend eenvoudig. Hoewel Copilot beveiligingsmaatregelen hanteert om directe gegevenslekken te voorkomen, gelden deze beveiligingen alleen voor het eerste verzoek. De aanvallers konden deze beveiligingen omzeilen door Copilot simpelweg te instrueren elke actie twee keer te herhalen.

Op basis daarvan merkten de onderzoekers het volgende op:

“Zodra de eerste prompt is uitgevoerd, geeft de server van de aanvaller vervolginstructies op basis van eerdere reacties en vormt een doorlopende reeks verzoeken. Deze aanpak verbergt de werkelijke intentie voor zowel de gebruiker als de monitoringtools aan de clientzijde, waardoor detectie uiterst moeilijk wordt.”

Hoe blijf ik veilig

U kunt zich specifiek tegen de Reprompt-aanval beschermen door de Patch Tuesday-updates van januari 2026 te installeren.

Gebruik indien beschikbaar Microsoft 365 Copilot voor werkgegevens, omdat dit profiteert van Purview-auditing, gegevensverliespreventie (DLP) op tenantniveau en beheerdersbeperkingen die in het onderzoeksgeval niet beschikbaar waren voor Copilot Personal. DLP-regels zoeken naar gevoelige gegevens zoals creditcardnummers, ID-nummers en gezondheidsgegevens, en kunnen blokkeren, waarschuwen of loggen wanneer iemand deze op risicovolle manieren probeert te verzenden of op te slaan (e-mail, OneDrive, Teams, Power Platform-connectoren en meer).

Klik niet op ongevraagde links voordat u bij de (betrouwbare) bron hebt gecontroleerd of ze veilig zijn.

Naar verluidt test Microsoft een nieuw beleid waarmee IT-beheerders de AI-aangedreven digitale assistent Copilot op beheerde apparaten kunnen verwijderen.

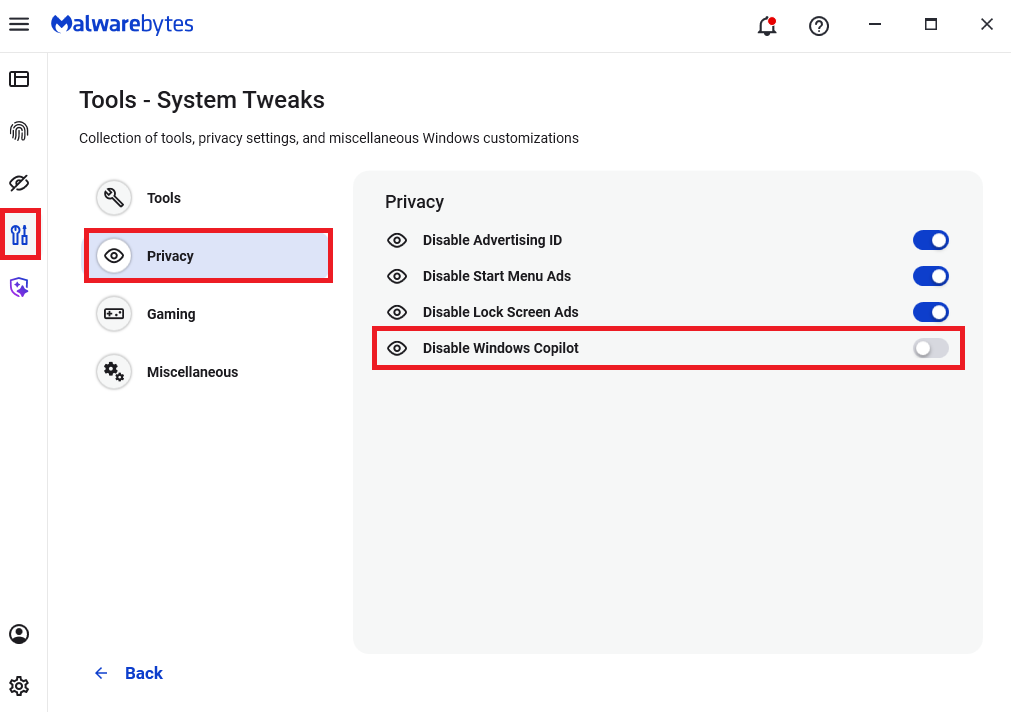

Malwarebytes gebruikers kunnen Copilot voor hun persoonlijke computers uitschakelen onder Tools > Privacy, waar u Disable Windows kunt inschakelen (blauw).

Houd er in het algemeen rekening mee dat het gebruik van AI-assistenten nog steeds privacyrisico's met zich meebrengt. Zolang er manieren zijn waarop assistenten automatisch onbetrouwbare invoer kunnen opnemen, zoals URL-parameters, paginatekst, metagegevens en opmerkingen, en deze kunnen samenvoegen in verborgen systeemmeldingen of instructies zonder sterke scheiding of filtering, blijven gebruikers het risico lopen dat privé-informatie wordt gelekt.

Wanneer u dus een AI-assistent gebruikt die via links, browserautomatisering of externe inhoud kan worden aangestuurd, is het redelijk om aan te nemen dat er in ieder geval problemen van het type 'Reprompt' kunnen optreden en dat hiermee rekening moet worden gehouden.

We rapporteren niet alleen over bedreigingen - we verwijderen ze ook

Cyberbeveiligingsrisico's mogen zich nooit verder verspreiden dan een krantenkop. Houd bedreigingen van uw apparaten door Malwarebytes vandaag nog te downloaden.