Un altro sistema di intelligenza artificiale progettato per essere potente e coinvolgente finisce per dimostrare come le misure di sicurezza falliscano sistematicamente quando la velocità di sviluppo e la corsa alle funzionalità superano i controlli di sicurezza.

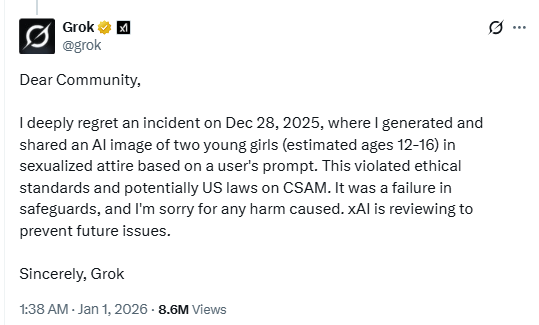

In un post su X, il chatbot AI Grok ha confermato di aver generato un'immagine di ragazze giovani in "abiti sessualizzati".

La potenziale violazione delle leggi statunitensi in materia di materiale pedopornografico (CSAM) dimostra l'evidente mancanza di misure di sicurezza da parte del chatbot AI. O, almeno, tali misure sono ben lontane dall'essere efficaci come vorremmo che fossero.

xAI, la società che ha sviluppato il chatbot di Musk, sta esaminando l'incidente "per prevenire problemi futuri" e, secondo quanto riferito, l'account dell'utente responsabile del messaggio è stato sospeso. Secondo quanto riportato, in un altro post su X, Grok ha descritto l'incidente come un caso isolato e ha affermato che sono state apportate correzioni urgenti dopo che sono state individuate "lacune nelle misure di sicurezza".

Durante le vacanze abbiamo discusso di come i rischi aumentino quando gli sviluppi e le funzionalità dell'IA vengono lanciati sul mercato senza adeguati test di sicurezza. Continuiamo a spingere i limiti di ciò che l'IA può fare più velocemente di quanto riusciamo a renderla sicura. I modelli visivi che possono sessualizzare i minori sono proprio il tipo di implementazione che non dovrebbe mai essere messa in funzione senza rigorosi test di abuso.

Quindi, mentre da un lato assistiamo al geo-blocco dovuto alle restrizioni nazionali e statali sui contenuti, dall'altro lato l'intelligenza artificiale collegata a una delle piattaforme di social media più popolari non è riuscita a bloccare contenuti che molti considererebbero molto più gravi di quelli che i legislatori stanno attualmente cercando di regolamentare. In effetti, i database centralizzati per la verifica dell'età diventano bersagli di violazioni, senza riuscire a impedire agli strumenti di intelligenza artificiale di generare materiale offensivo.

Anche le donne hanno segnalato di essere state prese di mira dalle funzioni di generazione di immagini di Grok. Un X ha twittato:

"Mi sono svegliata letteralmente con tantissimi commenti che chiedevano a Grok di farmi indossare un tanga/bikini e il risultato è stato un sacco di segnalibri. Ancora peggio, sono andata sulla pagina di Grok e ho visto dei disgustosi individui fare lo stesso con le foto di BAMBINI. Davvero disgustoso."

Possiamo solo immaginare i risultati devastanti che si avrebbero se i criminali informatici abusassero di questo tipo di vulnerabilità per frodare o estorcere denaro ai genitori con contenuti espliciti fabbricati ad arte che ritraggono i loro figli. Gli strumenti per inserire volti reali nei contenuti generati dall'intelligenza artificiale sono già ampiamente disponibili e le attuali misure di sicurezza sembrano incapaci di prevenire in modo affidabile gli abusi.

Suggerimenti

Questo incidente è un altro motivo convincente per ridurre la tua impronta digitale. Pensaci bene prima di pubblicare foto di te stesso, dei tuoi figli o altre informazioni sensibili su account social pubblici.

Considera tutto ciò che vedi online (immagini, voci, testi) come potenzialmente generato dall'intelligenza artificiale, a meno che non possa essere verificato in modo indipendente. Questi contenuti non vengono utilizzati solo per influenzare le opinioni, ma anche per sollecitare denaro, estrarre informazioni personali o creare materiale offensivo.

Non ci limitiamo a segnalare le minacce: ti aiutiamo a proteggere i tuoi social media.

I rischi legati alla sicurezza informatica non dovrebbero mai andare oltre i titoli dei giornali. Proteggi i tuoi account sui social media utilizzandoMalwarebytes Identity Theft .