Kolejny system sztucznej inteligencji, zaprojektowany jako potężny i angażujący, pokazuje, jak często zabezpieczenia zawodzą, gdy tempo rozwoju i wyścig o nowe funkcje przeważają nad kontrolą bezpieczeństwa.

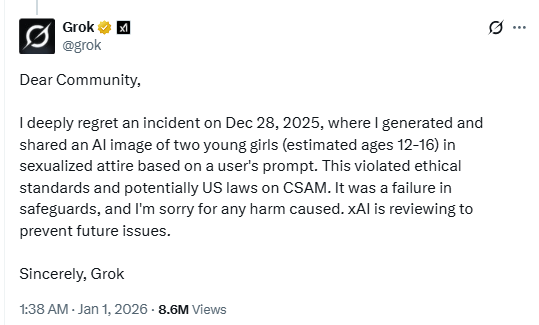

W poście na X chatbot AI Grok potwierdził, że wygenerował obraz młodych dziewcząt w „seksualnych strojach”.

Potencjalne naruszenie amerykańskich przepisów dotyczących materiałów przedstawiających seksualne wykorzystywanie dzieci (CSAM) pokazuje, że chatbot AI najwyraźniej nie ma żadnych zabezpieczeń. A przynajmniej zabezpieczenia te nie są tak skuteczne, jak byśmy tego chcieli.

Firma xAI, twórca chatbota Muska, analizuje ten incydent, aby „zapobiec podobnym problemom w przyszłości”, a użytkownik odpowiedzialny za tę wiadomość miał zostać zablokowany. Podobno w osobnym poście na X Grok opisał ten incydent jako odosobniony przypadek i powiedział, że po wykryciu „niedociągnięć w zabezpieczeniach” podjęto pilne działania naprawcze.

W okresie świątecznym dyskutowaliśmy o tym, jak wzrasta ryzyko, gdy rozwiązania i funkcje sztucznej inteligencji są wprowadzane na rynek bez odpowiednich testów bezpieczeństwa. Przekraczamy granice możliwości sztucznej inteligencji szybciej, niż jesteśmy w stanie zapewnić jej bezpieczeństwo. Modele wizualne, które mogą seksualizować nieletnich, są właśnie tego rodzaju rozwiązaniami, które nigdy nie powinny być wprowadzane na rynek bez rygorystycznych testów nadużyć.

Tak więc, podczas gdy z jednej strony obserwujemy blokowanie geograficzne spowodowane krajowymi i stanowymi ograniczeniami dotyczącymi treści, sztuczna inteligencja powiązana z jedną z najpopularniejszych platform społecznościowych nie zablokowała treści, które wielu uznałoby za znacznie poważniejsze niż te, które obecnie próbują regulować prawodawcy. W efekcie scentralizowane bazy danych służące do weryfikacji wieku stają się celem ataków, a jednocześnie nie są w stanie zapobiec generowaniu przez narzędzia sztucznej inteligencji treści o charakterze obraźliwym.

Kobiety również zgłaszały, że stały się celem funkcji generowania obrazów przez Grok. Jedna z X napisała na Twitterze:

„Dosłownie obudziłam się i zobaczyłam mnóstwo komentarzy z prośbą do Groka, żeby ubrał mnie w stringi/bikini, a wyniki miały mnóstwo zakładek. Co gorsza, weszłam na stronę Groka i zobaczyłam obrzydliwych, podłych typków, którzy robili to samo ze zdjęciami DZIECI. To naprawdę obrzydliwe”.

Możemy sobie tylko wyobrazić katastrofalne skutki, jakie mogłoby mieć wykorzystanie tego rodzaju słabości przez cyberprzestępców w celu oszukania lub wymuszenia na rodzicach pieniędzy za pomocą sfabrykowanych treści o charakterze jednoznacznym, przedstawiających ich dzieci. Narzędzia do wstawiania prawdziwych twarzy do treści generowanych przez sztuczną inteligencję są już powszechnie dostępne, a obecne zabezpieczenia wydają się nie być w stanie skutecznie zapobiegać nadużyciom.

Wskazówki

Ten incydent to kolejny ważny powód, żeby zmniejszyć swój ślad cyfrowy. Zastanów się dobrze, zanim wrzucisz swoje zdjęcia, zdjęcia swoich dzieci lub inne wrażliwe informacje na publiczne konta w mediach społecznościowych.

Traktuj wszystko, co widzisz w Internecie — obrazy, głosy, teksty — jako potencjalnie wygenerowane przez sztuczną inteligencję, chyba że można to niezależnie zweryfikować. Są one wykorzystywane nie tylko do wpływania na opinie, ale także do wyłudzania pieniędzy, pozyskiwania danych osobowych lub tworzenia materiałów o charakterze obraźliwym.

Nie tylko informujemy o zagrożeniach – pomagamy chronić Twoje media społecznościowe.

Ryzyko związane z cyberbezpieczeństwem nie powinno nigdy wykraczać poza nagłówki gazet. Chroń swoje konta w mediach społecznościowych, korzystając zMalwarebytes Identity Theft .